« On veut du ROIIIIIII » *revolver pointé sur la tempe*.

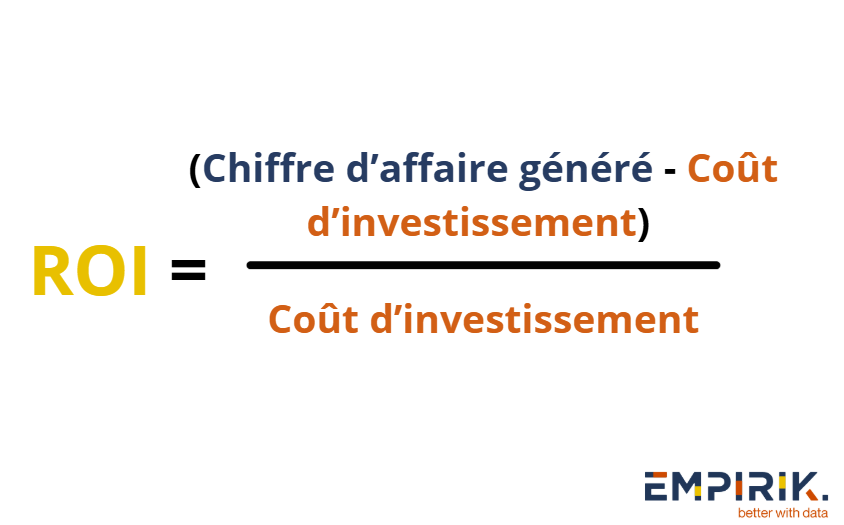

Bon, ce besoin est rarement demandé de manière aussi extrême mais c’est bien souvent l’objectif naturel du client qui investit pour son commerce et nous confie sa stratégie SEO. Ce ROI, on peut l’optimiser de deux façons : augmenter les revenus, bien sûr, mais aussi (et c’est souvent négligé) réduire les coûts. Et c’est exactement ce dont on va parler aujourd’hui.

Réduire les coûts pour nous qui travaillons dans le référencement naturel c’est principalement limiter son temps nécessaire à travailler sur le projet. Car en SEO il est facile de se perdre dans une liste interminable d’optimisations supposément bénéfiques. Entre les rumeurs d’untel qui dit que c’est important, les derniers hacks à la mode, les optimisations qui étaient pertinentes avant mais n’ont pas survécu aux évolutions de Google et les inventions farfelues …

Dans mon quotidien de consultant chez l’agence SEO à Lyon Empirik, j’ai appris une chose essentielle : identifier les actions à fort impact est aussi important que d’éviter celles qui n’en ont pas, ou très peu. Nous allons donc passer en revue les différentes actions qui, je trouve, n’en valent pas la peine la plupart du temps.

Le désaveu de liens

Vous avez reçu une alerte sur votre outil concernant des « liens toxiques » ? Respirez un coup et reposez ce fichier de désaveu … Google ignore déjà naturellement les mauvais liens. L’outil de désaveu ? Dans 99% des cas, il ne sert à rien. Il se dit qu’il pourrait être utile dans le cas d’une pénalité manuelle mais je n’ai jamais eu affaire à ce cas.

Mais le pire, c’est que l’utiliser peut être contre-productif. Vous jugez qu’un lien est toxique, mais qu’en est-il des robots Google ? Ont-ils vraiment les mêmes critères que vous ? Supprimer en masse des liens que vous considérez comme mauvais, c’est prendre le risque de se priver de backlinks qui, malgré tout, transmettaient un peu de jus. Et perdre du jus, c’est potentiellement perdre des positions et du trafic.

Bing a déjà supprimé son outil de désaveu, Google lui, selon ses récentes annonces, est en train de préparer son euthanasie. John Mueller (porte parole de Google Search) le répète : le concept de « lien toxique » n’existe pas. Mais ça n’empêche pas certains outils SEO (coucou Semrush 👀) d’en faire un argument marketing en vendant des metrics flippantes sur des liens qui, en réalité, n’ont aucun impact.

Mais alors pourquoi il est là cet outil de désaveu s’il ne sert à rien ? Patrick Valibus (président de la FEPSEM) avance une théorie : il existerait surtout pour nourrir le machine learning de Google. En désavouant certains liens, on indique à Google qu’il s’agit de liens de mauvaise qualité, ce qui peut l’aider à mieux identifier et ignorer ce type de liens à l’avenir.

Les optimisations d’images

L’attribut Alt c’est important pour rendre votre page web accessible à tous, notamment pour les personnes malvoyantes. Mais d’expérience je n’ai jamais réussi à obtenir des résultats en ajoutant mes mots-clés dedans. Pensez accessibilité, pas forcément SEO, surtout quand l’image n’a rien à voir avec le mot-clé ciblé ça n’a aucun sens de se forcer à l’ajouter.

Il en va de même pour le nom des fichiers des images. Malgré l’existence de plugins dédiés sur WordPress, mes tests montrent qu’avoir ses mots-clés dans le nom du fichier n’a pas d’influence notable sur le référencement.

Faire une page pour chaque mot-clé ciblé : Et la clusterisation alors ?

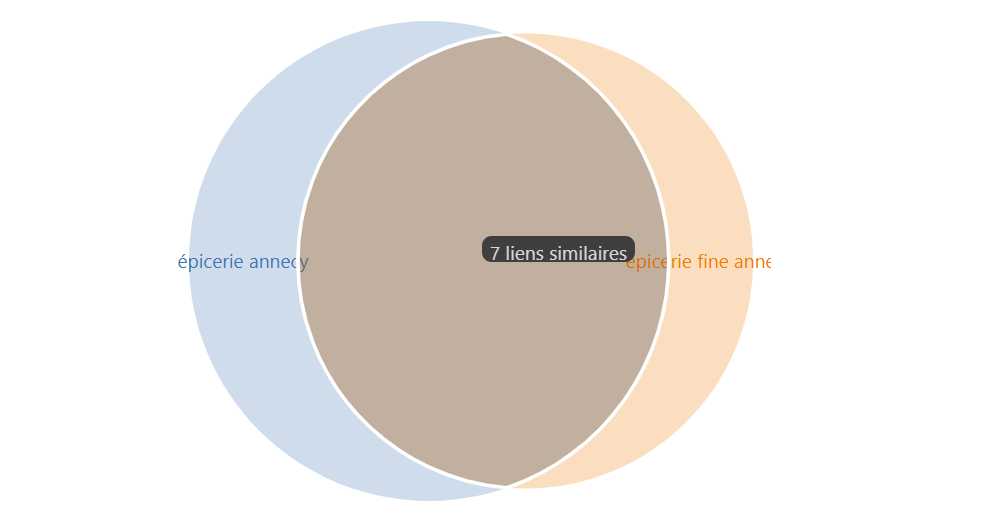

L’adage « 1 mot-clé = 1 page » peut porter à confusion car une page peut tout à fait se positionner sur une dizaine de mots-clés. Avec la clusterisation l’idée est de passer un peu de temps à tout regrouper en amont pour éviter d’en perdre à devoir générer trop de contenus qui finiront probablement par se cannibaliser.

La clusterisation permet de regrouper automatiquement des mots-clés proches en ensembles cohérents, réduisant drastiquement le volume à traiter. Elle repose sur un principe simple : si deux mots-clés affichent au moins 40 % de résultats identiques dans Google, il est souvent plus efficace de les cibler sur une seule et même page. Prenons l’exemple de « épicerie Annecy » et « épicerie fine Annecy« . Une analyse des SERP montre que leurs résultats sont assez similaires (voir image ci-dessus), ce qui signifie qu’une seule page optimisée peut capter efficacement le trafic des deux requêtes.

Les méta-données : focus sur l’essentiel

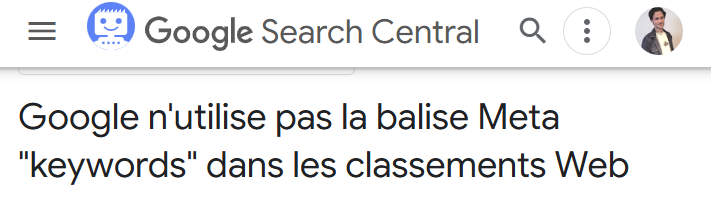

La meta keywords, un vestige du passé

La balise meta keywords était utilisée par les tout premiers moteurs de recherche mais Google l’ignore depuis ses débuts. Elle semble rester pertinente uniquement pour faire une stratégie SEO sur Yandex (Russie) et Baidu (Chine), car leurs équipes l’évoquent dans leur documentation officielle.

La meta description

La meta description n’influence pas directement le classement SEO. Mot-clé, pas mot-clé ça ne changera pas vos positions. Son principal intérêt réside dans l’amélioration potentielle du CTR. La présence de la requête de l’utilisateur peut la faire apparaître en gras dans les résultats, certes, mais étant donné que Google reformule lui même plus de 70% des meta descriptions ça signifie qu’il va falloir y passer du temps pour des résultats vraisemblablement infimes.

Je passe dessus uniquement quand il n’y a rien de mieux à faire (ce qui n’arrive jamais haha).

Le score PageSpeed Insights à 100%

C’est comme votre batterie de téléphone : ça marche très bien même si c’est à 70%, mais ça devient critique si ça passe à 20%.

Je vous invite à vérifier les score PageSpeed Insights des 3 premiers sur chaque requête qui vous intéresse, vous seriez surpris de voir que très peu ont au final un score vert. C’est un outil précieux pour évaluer la performance web, mais son lien direct avec le classement dans les résultats de recherche de Google est nuancé. Le seul critère pouvant concrètement pénaliser votre positionnement est le TTFB qui, s’il est mauvais, peut compliquer le crawl de Google sur votre site.

Corrigez le 20/80 des éléments bloquants dans le rapport de Pagespeed, mais ne vous fatiguez pas à vouloir atteindre un score parfait. Si l’on prend par exemple le mot-clé « vélo électrique » on remarque que les mieux positionnés n’ont pas des métriques irréprochables …

La structure Hn

Une structure logique des titres est recommandée en SEO, mais une hiérarchie imparfaite (comme un H3 avant un H2) n’est généralement pas la cause d’un mauvais classement.

Le nombre de mots

Le nombre de mots n’est pas un critère codé en dur dans les algorithmes de classement de Google. Et si au delà du SEO on s’intéresse à l’expérience utilisateur c’est se tirer une balle dans le pied que de gonfler artificiellement son nombre de mots avec des phrases à rallonge ou des paragraphes sans intérêt.

Je ne m’attarderai pas là dessus mais les Google Leaks ont tout de même expliqué que la pertinence d’un contenu ne se calcule pas uniquement avec le temps passé sur la page.

La corrélation parfois observée entre les contenus longs et un bon classement s’explique souvent par d’autres facteurs, comme des ressources plus importantes investies dans le SEO global.

Rallonger un contenu mal positionné ne vaut la peine uniquement si vous avez de nouvelles informations importantes à ajouter.

La densité de mot-clé

En 2012 déjà, Matt Cutts expliquait que la densité de mot-clé n’était pas un critère pris en compte par Google. Les algorithmes (notamment QBST) analysent désormais :

- L’emplacement des mots dans le document

- Les mots, les synonymes, les variantes, et les concepts associés

- La distance relative entre les mots similaires

Si vous souhaitez satisfaire les attentes de Google en terme de choix de mots sur une requête donnée vous pouvez vous équiper d’outils sémantiques comme Thot SEO, YourTextGuru, Semrank, Serpmantics …

Changer l’url pour ajouter un mot-clé

Oui, les mots-clés dans l’URL, c’est un petit plus… mais c’est vraiment petit. L’impact sur le SEO est tellement marginal qu’il ne justifie pas de modifier les urls pour ça vu les complications qui viennent avec. Car si vous touchez à une URL, il faudra impérativement mettre en place une redirection 301 depuis l’ancienne vers la nouvelle. Et si vous vous amusez à faire ça en masse, bonjour le carnage technique : risque de redirections en cascade, pertes de jus SEO, erreurs 404 à la pelle… Bref, ce n’est pas la meilleure idée.

Ne plus se faire avoir par des pratiques superflues

Cette liste est un début pour regagner votre temps précieux, mais comment éviter de tomber dans d’autres pièges à l’avenir ?

D’abord, échangez avec les experts de la communauté. Le référencement naturel est un domaine en perpétuelle évolution, et les retours d’expérience des autres professionnels sont une mine d’or. Sur Twitter, LinkedIn, sur Discord, dans les conférences (celles de la Fepsem par exemple), sur les forums spécialisés… Les discussions permettent d’identifier rapidement ce qui fonctionne et ce qui relève du mythe.

Ensuite, testez. Rien ne remplace l’expérimentation. Google fonctionne en boîte noire, et ses algorithmes évoluent sans cesse. Faire ses propres tests, c’est se donner les moyens de voir ce qui bouge réellement dans les SERP et d’adapter ses actions en conséquence.

Enfin, immergez-vous dans la logique du moteur de recherche. Lire les brevets de Google, la documentation officielle, analyser les mises à jour… Tout ça permet de mieux comprendre comment et pourquoi un site se positionne bien ou non. Plutôt que de suivre aveuglément des recommandations parfois dépassées, il vaut mieux comprendre comment on construit un moteur de recherche, comprendre ce qu’il pertinent de faire pour Google et surtout imaginer si c’est possible de le faire à l’échelle de millions de milliards de page sans exploser le budget.

J’espère que le temps perdu à lire cet article vous aidera à en gagner plus tard !

Consultant chez Empirik, l’agence SEO qui booste votre business grâce à vos données.